AI常用词汇

GPT (Generative Pre-trained Transformer)

是由美国OpenAI公司开发的AI模型,如ChatGPT-4o,ChatGPT-4o mini这样的模型。其中Chat是聊天的意思。

Model Compression

模型压缩技术:它旨在减小模型体积、降低计算资源消耗并提升推理速度,同时尽量保持模型性能。具体来说,模型压缩技术做了数值精度缩减(Quantization)、操作合并(Operation Merging)、剪枝(Pruning)、知识蒸馏(Knowledge Distillation)、模块替换(Module Replacement)、低秩分解(Low - Rank Factorization)这样的操作。一般就是说把完整参数的模型,变小更少参数的模型。

如:DeepSeek-R1-Distill-Qwen-1.5B-GGUF是通过量化(Quantization)和知识蒸馏(Knowledge Distillation)而成可以降低硬件需求的模型。

DeepSeek

深度求索:是一款完全由国内团队打造的开源AI模型,其主要特色是资源要求少,并且完全开源。

- 过混合专家(MoE)架构构建万亿参数模型,但是每次使用只是激活少量专家,从而节省大量算力。

- 自动切换精度(PF16->INT4),有的专家模型不需要用到高精度参数,从而节省大量内存。

- 完全开源FlashMLA、Claude 3.7 Sonnet、DeepGEMM、DualPipe、EPLB、3FS、DeepEP、profile-data等技术,技术共享让全球AI能上了一个台阶。

Token

文本处理的基本单元,中文以词或字拆分,英文常采用子词编码。一般也是开放接口的AI模型的计费模式。

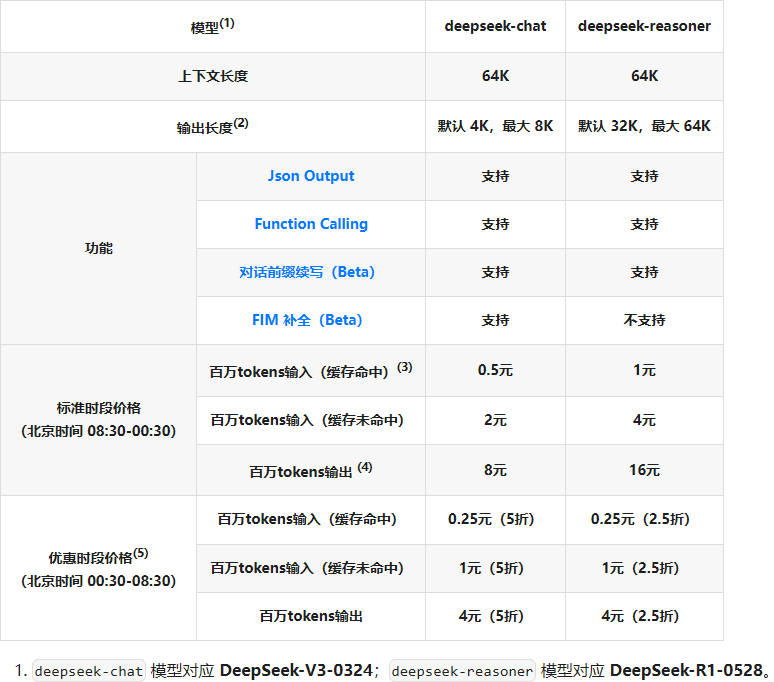

如下图是DeepSeek的收费,每100万个Token命中收费0.5元人民币。

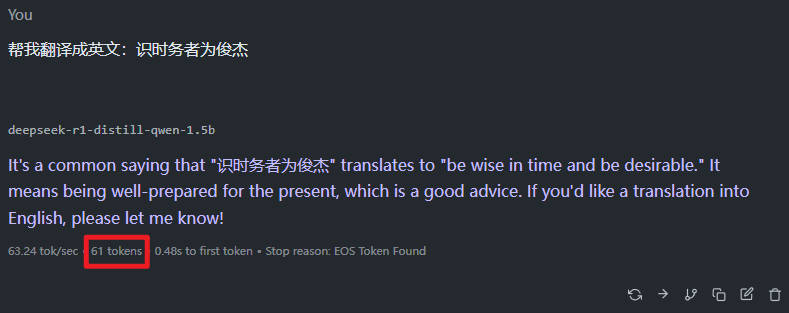

下图的工具可以显示Token的消耗情况。

Transformer

基于自注意力机制的模型架构,革新NLP领域。应用场景:文本生成、机器翻译、问答系统、对话系统等。

NLP (Natural Language Processing)

自然语言处理:使计算机理解、生成人类语言的技术

CNN (Convolutional Neural Network)

卷积神经网络:主要用于处理具有类似网格结构的数据,尤其在图像处理领域应用广泛,是目前最为先进和流行的图像处理方法之一。应用场景:图像分类、目标检测、图像分割、人脸识别、风格迁移等。

GNN (Graph Neural Network)

图神经网络:用于学习包含大量连接的图的联结主义模型,是近年来出现的一种利用深度学习直接对图结构数据进行学习的框架。应用场景:社交网络分析、推荐系统、知识图谱、生物信息学、计算机视觉等领域。

Diffusion Model

扩散模型:一种基于概率扩散的生成式模型。应用领域:图像生成与增强、文本生成、语音合成等。Stable Diffusion绘图AI的名字就这样而来的,对标的还有Midjourney。

AGI (Artificial General Intelligence)

通用人工智能:具备人类全面认知能力的AI系统(尚未实现)

MoE (Mixture of Experts)

混合专家模型:通过动态分配专家提升计算效率。DeepSeek之所以高效,就是灵活运用了MoE混合专家模型。

Agent (智能体)

能感知环境并自主决策的AI实体

Multi-Agent System

多智能体系统:多个智能体协作或竞争完成任务。如字节跳动的CoZi,致远互联CoMi。

ASR (Automatic Speech Recognition)

自动语音识别:将语音转换为文本的技术。做得比较出名的是讯飞、飞书、腾讯会议等。

TTS (Text-to-Speech)

文本转语音:将文字转为真人发音的技术。现在很多网上的解说、说书都是用了这样的技术,可以做到以假乱真。

RPA (Robotics Process Automation)

机器人流程自动化:模拟人类操作完成重复性任务

Fine-tuning

模型微调:在已有预训练模型的基础上,根据特定任务的需求对模型进行进一步的调整和优化,是深度学习领域尤其是自然语言处理、计算机视觉等需要大量数据和计算资源任务中常用的技术。如DeepSeek可以通过微调来让某些能力更加出众,如处理严肃问题的政务问答、公文编写等。

模型微调的成本巨大,分别是GPU、存储、数据、工程师和软件与云服务等。如DeepSeek做一次模型微调可能需要500万美元费用。

RAG (Retrieval-Augmented Generation)

检索增强生成:一般是配合大模型、向量库、提示词来做成AI知识库。这种技术可以避免模型微调(Fine-tuning)的高成本。使用RAG是解决AI幻觉的方法之一。

MCP (Model Context Protocol)

模型上下文协议:Anthropic推出的开源协议,旨在实现大语言模型与外部数据源和工具的集成,用来在大模型和数据源之间建立安全双向的连接。该协议是专为高效获得模型所需要上下文信息而设计的通用接口,可以推动大语言模型应用的标准化和去中心化。

OCR(Optical Character Recognition)

光学字符识别:配合AI的分析能力,可以实现自动填单等的功能,通过一定的训练,填写某些单据的时候能力会提高,如发票、公文这样格式稳定的。但是合同、协同这样每次都不一样的,效果就会差一些。

AI计算芯片

AI的算力基本都来自通用或专用GPU芯片,如:英伟达NVIDIA的H200、华为昇腾 910B是我们听得最多的。从生态来看,英伟达还是最佳选择,但是通过兼容英伟达的CUDA或创作自己的AI开发生态,都是可行的。